2019 10/20 誤字修正

2019 10/26タイトル修正

従来の生物学的研究アプローチでは、通常、一度に1つの遺伝子またはいくつかの遺伝子を研究する。対照的に、ハイスループットゲノム、プロテオミクス、およびバイオインフォマティクススキャニングアプローチ(発現マイクロアレイ、プロモーターマイクロアレイ、プロテオミクス、ChIP-on-CHIPなど)は、研究者がゲノムの変化と調節を同時に特定の生物学的条件下での幅広い遺伝子で測定できる代替技術として出現している。これらのハイスループットテクノロジーは、通常、最終的な出力として大きな「興味深い」遺伝子リストを生成する。しかし、大規模な「興味深い」遺伝子リスト(サイズが数百から数千の範囲に及ぶ)の生物学的解釈は、依然として困難で困難な作業である。過去数十年にわたって、公共データベースに蓄積された生物学的知識を使用したバイオインフォマティクス手法[e.g. Gene Ontology(ref.1)]により、最もエンリッチされた適切な生物学の要約を組み立て大きな遺伝子リストを体系的に分析することを可能にする。 Onto-Express、MAPPFinder、GoMiner、DAVID、EASE、GeneMerge、およびFuncAssociateなど(ref.2〜10)を含むがこれらに限定されない多くのハイスループットエンリッチメントツールが2002〜2003年に独立して初期研究として開発されている。それ以来、エンリッチメント解析分野は非常に生産的であり、より多くの同様のツールが一般に利用可能になった。 2005年、約14のそのようなツールが収集され、Khatriらによってレビューされた。

(一部略)

過去数年間、バイオインフォマティクスエンリッチメントツールは、さまざまなハイスループット生物学研究のための大規模な遺伝子リストの遺伝子機能分析に貢献する非常に重要かつ成功した役割を果たしてきた。ただし、これらのバイオインフォマティクスエンリッチメントツールは、統一された方法やゴールドスタンダードがないため、まだ活発に成長および改善の段階にある。科学コミュニティでより多くのエンリッチメントツールが登場するにつれて、個々のツール開発グループまたはエンドユーザーは、自分の研究に対する既存のすべての研究の有用性を包括的に追跡することがますます困難になっている。この紛らわしいツールは、次のようないくつかの問題をもたらした。(i)圧倒的に多数のツール(論文の表1、約68ツール)の中で、ツールごとにアルゴリズム/機能を包括的に比較および記憶することが難しい。 (ii)良い仕事が見落とされる可能性。 (iii)開発者が分野の広さを把握するのが難しいため、すでに存在するアイデアを開発するための冗長な努力。 (iv)開発者が最新の方法を認識していないため、新しくリリースされたツールで使用されている古いアイデア。 (v)エンドユーザーが非常に多くの圧倒的な選択肢の中から、どのエンリッチメントツールが分析ニーズに最も適しているかを判断するのが難しい。

この研究では、前述の状況に対処するための4つのセクションが含まれる。まず、現在利用可能な68のエンリッチメントツールを特定し (論文執筆時点)、その背後にある理論的根拠をさらに説明する。これにより、ツールの設計者、開発者、およびエンドユーザーは、既存のツールの全てではないにしても、ほとんどのツールを認識できるようになる。第二に、基礎となるアルゴリズムに従ってツールを3つの主要なカテゴリに一意に分類する。したがって、読者は、ツールごとのレイアウトを検索するのではなく、カテゴリロジックに従って68ツールのキーとなるスピリットをより簡単かつ迅速に把握できる。第三に、このペーパーでは、この分野に関連するいくつかの重要ではあるが、ほとんど回答のない質問や問題に焦点を当てる。議論される質問/問題が、より多くの注意、独立した思考、および分野での議論を促し、その後、近い将来により良いソリューションにつながることを願う。最後に、このペーパーは、フィールドの現在のステータスとトレンドで締めくくる。

(一部略)

ツールの開発者またはエンドユーザーが利用可能な多くのツールの中から特定の機能を検索しているとき、適切な分類なしに68すべてのツールの機能を理解することは簡単な作業ではない。ここでは、アルゴリズムの違いに基づいて、現在の(論文執筆時点)68のエンリッチメントツールを3つのクラス、Singular enrichment analysis (SEA)、Gene Set Enrichment Analysis (GSEA); modular enrichment analysis(MEA)に分類した。

クラス1:SEA

エンリッチメント解析の最も伝統的な戦略は、ユーザーが事前に選択した(例えば、P値≤0.05および倍率変化≥1.5のt検定による実験サンプルと対照サンプル間で選択的に発現した遺伝子)「興味のある」遺伝子を取得し、線形モードで各アノテーションterm1つずつのエンリッチを繰り返しテストすることである。その後、エンリッチメントP値の閾値をパスしエンリッチメントされた個々のtermは、エンリッチメント確率(エンリッチメントP値)の順に並べられ表形式でレポートされる。エンリッチメントP値の計算、つまり純粋なランダムチャンスと比較して特定の生物学的クラスに有意にヒットするリスト内の遺伝子数は、いくつかの一般的によく知られた統計的手法(11,12,76)を使用して実行できる。これにはカイ二乗、フィッシャーの正確確率検定、二項分布、超幾何分布などが含まれる(表1)。エンリッチメントのP値に関する詳細は、このペーパーの後半のセクションで説明している。

SEAの戦略と出力形式は単純だが、SEAは、あらゆる種類のハイスループットゲノム研究またはバイオインフォマティクスソフトウェアパッケージから生成される可能性のある、大きな遺伝子リストの背後にある主要な生物学的意味を抽出する非常に効率的な方法である。初期のツールのほとんど(GoMiner、Onto-Express、DAVID、EASEなど)と最近リリースされた多くのツール(GOEAST、GFinderなど)は、この戦略を採用し、多くのゲノム研究で大きな成功を収めた。ただし、このクラスのツールの一般的な弱点は、termの線形出力が非常に大きく、数百から数千に及ぶことである。したがって、データ分析者の焦点と関連termの相互関係を薄めることがあり得る。たとえば、アポトーシス、プログラムされた細胞死、アポトーシスの誘導、抗アポトーシス、アポトーシスの調節などの関連するGO termは、大きな線形出力のさまざまな位置に広がっている。数百または数千の他のtermの中で、関連する生物学termの相互関係に焦点を合わせるのは困難である。さらに、事前に選択された遺伝子リストの品質は、エンリッチメント解析に大きく影響する可能性があり、異なる統計的手法またはカットオフしきい値を使用すると、SEA分析がある程度不安定になる。

クラス2:遺伝子セット濃縮分析(GSEA)

GSEAはSEAの核心を担うが、SEAと比較してエンリッチメントP値を計算する明確なアルゴリズムを備えている(35)。この分野の人々は、GSEA戦略に大きな関心と期待を寄せている。GSEAのユニークなアイデアは、「カットオフなし」戦略であり、重要な遺伝子を選択せずにマイクロアレイ実験からすべての遺伝子を取得する(例:P値≤0.05および倍率変化≥1.5の遺伝子)。この戦略は、2つの側面でエンリッチメント解析に役立つ。1)従来のエンリッチメント解析に影響を与える可能性のある、典型的な遺伝子選択ステップの任意の要因を削減する。2)マイクロアレイ実験から得られたすべての情報を使用して、選択閾値を超えることができない最小の変化遺伝子をさまざまな程度でエンリッチメント解析に寄与できるようにする。最大エンリッチメントスコア(MES)は、アノテーションカテゴリのすべての遺伝子メンバーのランク順から計算される。その後、MESをランダムにシャッフルされたMES分布(Kolmogorov–Smirnovのような統計)に一致させることにより、エンリッチメントP値を取得できる(35)。 ErmineJ(31)、FatiScan(55)、MEGO(36)、PAGE(29)、MetaGF、Go-Mapper(22)、ADGO(45)など、「ノーカットオフ」戦略を使用するGSEAクラスのその他のエンリッチメントツール)など、zスコア、t検定、順列分析などのパラメトリック統計アプローチを採用している。これらのアプローチは、すべての遺伝子の実験値(たとえば、倍数変化)を各アノテーションされたtermの計算に直接取り込む。総じて、総実験値を機能データマイニングに統合する最近のGSEAツールは、従来のSEAを補完する多くの可能性を持つ興味深いトレンドである(47,77–79)。

ただし、GSEAクラスのツールには、いくつかの一般的な制限も関連付けられている。まず、「カットオフなし」戦略はGSEAの主な利点だが、多くの生物学的研究において大きな制限になりつつある。GSEAメソッドでは、入力としてゲノム全体の遺伝子のそれぞれについて、要約された生物学的価値(例:倍数変化)が必要となる。生物学的研究とゲノムプラットフォームが複雑な場合、遺伝子の多くの生物学的側面を1つの意味のある値に要約することは困難な場合がある。たとえば、SNPマイクロアレイに由来する各遺伝子は、サイズ、P値、物理的距離、疾患領域、LD(連鎖不平衡)強度およびSNP遺伝子の位置(エクソン、またはイントロン) など。このような生物学のさまざまな側面を1つの包括的な値にまとめることは、まだ非常に実験的な手順である。同様の課題は、新興のゲノムプラットフォームの多く(SNP、エクソン、プロモーターマイクロアレイなど)で見られる場合がある。例の状況は、GSEAで必要な入力データ構造の要件で完全にまたは部分的に失敗する。別の例として、多くの臨床マイクロアレイ研究には、疾患/正常、年齢、性別、薬物治療/制御、試薬バッチ効果、動物バッチ効果などの複数の因子(交絡因子のこと)/バリアントが同時に含まれる。 ANOVA、時系列分析、生存分析などは、多変量、複数のタイムポイント、バッチ効果などを同時に処理して、データマイニングの興味深い遺伝子リストを作成するより強い検定力になる。多くの同様のケースでは、上流のデータ処理と包括的な遺伝子選択統計を単純に回避したり、GSEAに置き換えることはできない。さらに、より高い位置にランク付けされた遺伝子(通常、より大きな違い、たとえば倍数変化を伴う)は、GSEAのエンリッチメントのP値を駆動する(非常に重要な)大きな検定力である。したがって、根本的な仮定は、大きな調節(例えば、倍数変化)を持つ遺伝子が生物学により貢献しているということになる。明らかに、これは実際の生物学では必ずしも真実ではない。生物学者は、いくつかのシグナル伝達遺伝子の小さな変化が下流の生物学的影響を大きくする可能性があることを知っている。対照的に、代謝遺伝子のいくつかの大きな変化は、他の小さいが重要なシグナル調節イベントの結果である可能性がある。研究者が尋ねている質問では、わずかに変化したシグナル伝達遺伝子が主要に調節されている遺伝子よりも興味深い/重要なのかもしれない。

GSEAおよびSEAメソッドは、長年にわたってコミュニティで利用されてきた。驚くべきことに、包括的で体系的な並列比較はまだ利用できない。最近の研究では、DAVIDメソッド(SEA / MEAメソッド)とErmineJ(GSEAメソッド)を使用して同じデータセットを実行した(60)。予想どおり、両方の方法の結果は互いに非常に一貫していた。 GSEAのエンリッチメント計算の主な推進力は、大きく変化する遺伝子であるため、一貫性は理にかなっている。さらに、これらの遺伝子は、従来の遺伝子選択手順で選択される可能性が高いため、SEA方法とGSEA方法で非常に類似した結果が得られる。

クラス3:MEA

MEAは、SEAで見られる基本的なエンリッチメント計算を継承し、term間の関係を考慮することで追加のネットワーク検出アルゴリズムを組み込んでいる。Ontologizer(69)、topGO(41)、GENECODIS(59)、ADGO(45)、ProfCom(68)などの最近のツールは、エンリッチメント計算でGO termの相互関係を考慮することで発見の感度と特異性を改善すると主張した。すなわち、複合(結合)アノテーションtermの遺伝子をリファレンスバックグラウンドとして使用する。このアプローチの主な利点は、研究者がtermとtermの関係を利用できることである。この共同termには、個々のtermではなく、特定の研究のユニークな生物学的意味が含まれる。さらに、異種のアノテーションコンテンツを使用する場合、アノテーションtermは非常に冗長であり、同じ生物学的プロセスのさまざまな側面に関する強力な相互関係もある。このような関係を構築することは、データマイニング中の生物学の本質に一歩近づくことである。GoToolBox(18)は、関連するGO termまたは遺伝子をクラスター化する機能を開発した。これは、ネットワークコンテキストで遺伝子機能アノテーションを提供する。ただし、これらの関数は小さなスコープとGO termでのみ機能する。

(一部略)

現在のデータマイニング環境におけるエンリッチメントP値の役割の現実的位置付け

高スループットのエンリッチメントデータマイニング環境は非常に複雑である。ユーザー遺伝子リストのサイズのバリエーション、各アノテーションに関連付けられた遺伝子の数の偏差、注釈間の遺伝子の重複、アノテーションコンテンツの不完全性、遺伝子間の強い接続性/依存性、アノテーションコンテンツの不均衡な分布、および高/低アノテーションコンテンツの頻度は、この複雑さとバリエーションにつながるソースの例である。 (一部略)

1.現在のデータマイニング環境におけるエンリッチメントP値の役割の現実的位置付け

実際の実践では、多くのデータ分析者は、得られたエンリッチメントのP値を、助言的な役割を果たすスコアリングシステムとして扱うことがある。つまり、絶対的な意思決定の役割とは対照的に、関連するアノテーションtermのランク付けと提案を行う(82 )。分析者自身は、エンリッチメント解析ツールによって強調表示される最も関連性の高いエンリッチメントtermの観点から最終決定を下す際に依然として重要な役割を果たしている。アノテーションtermは非常に重要なエンリッチメントP値に関連付けられている場合があるが、先験的な生物学的知識に基づいて「意味をなさない」ため、エンリッチメントアノテーションterm(エンリッチメントP値<0.001のtermなど)の一部を破棄/無視することは珍しくない。このタイプの状況の類似した例は、ユーザーの元のクエリに関係のない結果を返すGoogle検索の例に似ている。結果について最終的な判断を下すのは、状況に関するユーザーの知識に基づいて、ユーザー次第である。まとめると、現在のエンリッチメント解析は、純粋な統計的解法ではなく、エンリッチメントのP値の助けを借りた、より探索的な手順である。豊富なtermが研究の先験的な生物学的知識に基づいて意味をなすという概念は、ユーザーが分析の閾値を調整し、それによって次のような質問に答えるのに役立つ最も重要なガイドラインとなる:「私のエンリッチメントP値のカットオフは0.05または0.01にすべきですか? 'または' 0.001のような有意なエンリッチメントP値を持つtermがあれば常に熟考する必要がありますか? 'または'どのエンリッチメントツールが私のデータセットでよりセンシティブになる可能性がありますか?

ユーザーのデータセットで多くの統計的手法を試して、可能な限り結果を比較することが、ユーザーの最大の利益になる。 (一部略)

2.エンリッチメントのP値に関する複数のテスト修正の制限を理解する

標準的な統計原則によれば、テストされるアノテーションが多いほど、ファミリー全体の偽陽性率が増加する可能性が高くなる(85,86)。結果リストでファミリー全体の偽陽性率を制御するために、Khatriらによるレビュー (11,12)では、エンリッチメントP値の複数のテスト修正を、同時にテストされる機能アノテーションカテゴリで実行する必要があることを示している。実際、ツールの大半は、Bonferroni、Benjamini–Hochberg、Holm、Q値、Permutationなどの方法でこのような修正を実行する(論文補足データ1)。前のセクションで説明したように、非常に複雑な遺伝子機能データマイニング環境を考えると、重要な問題は、実際の診断でそのような修正を適用することによって、発見の感度と特異性(1-偽陽性率)がどの程度改善されるかである。

多くのエンリッチメントツールがそのような修正方法を実装しているが、統計原則だけに基づいた利点を信じるのではなく、実際の分析環境でそのような修正の有無にかかわらず発見結果の改善に関する証拠を体系的に提供するツールはわずかである。最近、GOSSIP(27)は、実際のデータセットを備えたさまざまなツールによって提供されるさまざまな修正手法にわたって、発見の感度と特異性を包括的に比較した。分析に数千またはそれ以上のアノテーションtermが含まれている場合に過度に保守的なアプローチであることが知られている一般的な複数テスト修正技術は、人々が信じていたほど特異性を改善しない可能性があると結論付けられた。実際、これらの補正の保守的な性質のために、感度が悪影響を受ける可能性がある(27)。

生物学的データマイニング環境の複雑さを考えると、一般的な統計手法から導出されたエンリッチメントP値は非常に脆弱であり、統計手法自体だけでなく、アルゴリズム、データソース、個々の生物学的要因、処理によっても大きく影響される。発見の特異性は、非統計層の影響を大きく受ける。これは、複数のテスト修正で簡単に修正することはできない。 (一部略)

3.複数の遺伝子リストから導き出された濃縮分析結果のクロス比較

遺伝子リストが大きいほど統計的検出力が高くなり、わずかにエンリッチされたtermやに対して高い感度(よりsignificantなP値)が得られる。一方、大幅にエンリッチされたterm群とより幅広い termについては向かって低下する。したがって、遺伝子リストのサイズはエンリッチメントのP値に影響を与え、遺伝子リスト間でエンリッチとメントP値の絶対値を直接比較することを困難にする。課題に関係なく、複数のタイムコースデータセット間の変更/傾向を調査する際に、相互比較が必要かつ重要な場合がある。 GOBar(32)、Go-Mapper(22)、GOAlie、PageMan(51)high-throughput GoMiner(39)、GOEAST(70)などのツールは、これらの機能の一部を提供することを目的としている。ただし、これらのツールを使用する場合、ユーザーはP値比較の問題に留意する必要がある。特に遺伝子リストのサイズが互いに劇的に異なる場合、問題はさらに重大になる。比較に関するより包括的で適切なアルゴリズムは、この分野で依然として高い需要がある。

4.「正しい」遺伝子リファレンスバックグランドを設定する

ヒトゲノムの遺伝子の1%はキナーゼであり、ユーザーがマイクロアレイ実験で選択したユーザーの遺伝子のおよそ10%はキナーゼである。したがって、エンリッチメントを定量的に測定できる。特定の例について結論が得られる場合がある。つまり、キナーゼはユーザーの研究で豊富になり、したがって研究で重要な役割を果たす。ただし、10%だけでは、遺伝子リファンレスバックグラウンド(1%など)と比較しない限り、このような結論に至ることはできない。したがって、同じ統計手法とアノテーションコンテンツを使用している場合でも、異なる遺伝子リファンレスバックグラウンド設定はエンリッチメントをP値に大きな影響を与える可能性がある(12)。たとえば、GOToolBox(18)、GOstat(14)、GoMiner(10)、FatiGO(13)、GOTM(24)などのツールは、ゲノムの全遺伝子をグローバルリファレンスバックグラウンドとして使用する。遺伝子のリファンレスバックグラウンドとして絞り込まれた遺伝子セット(例:マイクロアレイにのみ存在する遺伝子)を使用するツール(例:Onto-Express)と比較して、より有意なP値が得られる傾向がある。さらに、DAVID(61)は、アレイ上に存在し、対応するアノテーションカテゴリの用termに関連付けられている遺伝子を遺伝子リファンレスバックグラウンドとして使用することで、より保守的になる傾向がある。さらに、多くのツールは、カスタマイズされた遺伝子リストを遺伝子リファンレスバックグラウンドとしてアップロードできる(論文補足データ1)。リファンレスバックグラウンドには「ゴールド」の基準はないが、一般的なガイドラインは、リファンレスバックグラウンドを研究対象のアノテーションカテゴリで選択できる遺伝子のプールとして設定することである(12)。たとえば、分析遺伝子リストが特定のチップで実施されたマイクロアレイ研究から得られた場合、マイクロアレイチップで見つかった総遺伝子は「正しい」リファンレスバックグラウンドであると思われる。しかし、マイクロアレイ検出範囲を下回る低発現レベル、および/または「悪い」プローブ設計などにより、研究中にチップ上の一部の遺伝子を選択する機会がほとんどまたはまったくない可能性があるため、完全ではない。遺伝子リファンレスバックグラウンドはエンリッチメントP値に直接影響を与えるが、同じ分析内で比較的類似した方法ですべてのtermのP値に影響を与える。異なる遺伝子リファレンスバックグラウンドで分析された同じデータセットの場合、termが異なるP値に関連付けられている場合でも、エンリッチされtatermの出力ランク/順序は比較的同じままである。出力におけるこのような安定したエンリッチの順序/ランクは絶対P値よりも重要であるため、同じデータセットでのアノテーションの調査と結論は、異なる遺伝子リファレンスバックグラウンドを使用する場合に類似して比較できる。 この意味で、遺伝子リファレンスバックグラウンドを設定する別の重要な原則は、同じ分析内で一貫した遺伝子リファレンスバックグラウンドを使用することである。

5.バックエンドアノテーションデータベースの拡張

(省略)

6.ユーザーの入力遺伝子識別子を利用可能な注釈に効率的にマッピングする

遺伝子識別子(ID)を対応するアノテーションコンテンツに効率的にマッピングできない場合、その後のデータマイニングは大幅に損なわれる。したがって、データベース内のIDからID、およびIDからアノテーションコンテンツのマッピングの包括性は、遺伝子リストを可能な限り高いアノテーションコンテンツに最大限に変換する最初のステップとして不可欠である。しかし、遺伝子/タンパク質を表す識別子が非常に冗長であり、それぞれ独立したバイオインフォマティクス組織によって維持されている場合、これは単純で些細な問題ではない。 NCBI Entrez Gene(89)、UniProt UniRef(90)、PIR-NREF(91)などの各主要バイオインフォマティクス組織内で識別子のクロスマッピングの問題が効果的に対処されたとしても、組織間でのリファレンス機能の弱さは以前存在する。たとえば、UniProtはRefSeq IDをカバーせず、NCBI Entrez GeneはPIR IDをまったく参照しない。異なるアノテーションデータベースが主要な遺伝子識別子システムとしてその1つだけを使用する場合、例えば、GeneRifは主要な関連識別子としてNCBI IDを採用し、InterProは主要な関連識別子としてUniProt / SwissProtを使用する(65)。一部のアノテーションコンテンツは特定のタイプのユーザー入力IDを優先しない。したがって、特定のタイプのIDについて、この問題に特に注意を払わなければ、重要なアノテーションコンテンツはユーザーの気付かないうちにハイスループット分析から簡単に除外される可能性があり、エンリッチメント分析が不完全または失敗することさえある。残念ながら、エンリッチメントツールは一般に、ID-to-IDおよびID-to-annotationマッピングの問題をどのように処理するかを十分に文書化していない。ほとんどのツールは、NCBI Entrez Geneデータベース(89)などの別の主要グループの既存の作業を採用している可能性がある。このような場合、ツールは多くのIDシステムをサポートすると主張するかもしれないが、前述の組織間の問題のために、すべてのタイプのIDがバックエンドアノテーションデータベースに完全に統合されることを意味しない。Onto-Translate(62)、MatchMiner(92)、IDConverter(93)、DAVID ID Converter(61)などの最近の取り組みにより、ユーザーは1つのタイプのIDを別のタイプに簡単に変換できる。さらに、それらは改善された相互リファレンス機能を提供するだけでなく、注釈コンテンツを充実させる。たとえば、DAVID Gene Conceptと呼ばれる手順によって遺伝子IDが再凝集された後、個々のソースのアノテーションと比較して、DAVIDナレッジベースの対応する遺伝子に10〜20%多いGO term を割り当てることができた(65) 。

7.探索機能とグラフィック表示の強化

(省略)

8.新しい強化ツールの分析機能の評価

68のツールと、このコレクションに含まれていない可能性のある追加ツールにより、すでにこの分野は非常に混雑している。ツールの多くは、他のツールとの相互比較を最小限に抑えている。適切な標準評価手順は、特に新しいツールの場合、ツール間で分析機能をより比較可能にする。さらに、優れた標準は、いくつかの新しいツールを本当に際立たせ、publicationsに余分な作業が現れるのを防ぐことができる。このような標準には、次のものが含まれるが、これらだけに限定はされない。分析のための異なる困難なレベルの予想される既知の生物学を備えた共通のデータセット(遺伝子リスト)相互比較の重要な側面(バックエンドデータベース、エンリッチメントP値、速度、探索能力、グラフィック表示など)など。まだ詳細な提案はないが、明らかにこの分野では標準が必要である。

9.さまざまな選択肢から最も適切なエンリッチメントツールを選択する

最適なエンリッチメントツールの選択は、ユーザーの調査ニーズ、ITエクスペリエンス、およびクエスチョンに大きく依存している。研究目標はプロジェクトごとに非常に多様であるため、正確なガイドラインはほとんど不可能である。ツールを選択する前に、ユーザーは「GOデータソースで十分ですか?、それ以上(パスウェイ、タンパク質ドメイン、タンパク質間相互作用など)必要ですか?」などの質問をすることができる。 「SEAのレポートで十分ですか、それとも相互関係を調べるためにMEAが本当に必要ですか?」; 「私の実験デザインは、GSEAの入力要件に適合するほど単純ですか、または遺伝子選択に包括的な統計的手法が必要ですか?」; 「R、スタンドアロンツール、またはWebツールを処理するIT機能は何ですか?」。その後、ユーザーの要件を最大限に満たすツールが論理的に選択できる。論文表2は、各ツールクラスの強度と制限を比較したものである。圧倒的な選択肢の中から個々のツールを検索する代わりに、研究者は最初に目的のツールクラス(つまり、SEA、GSEA、およびMEA)を見つけ、そのクラス内の個々のツールにさらに絞り込むことを勧める。補足データ1には、すべてのツールについて、ユーザーが興味を持ちそうな側面の一部がリストされている。

(一部略)

結論と展望

生物学的データマイニングの状況は複雑であるため、現在の状態では、現在のエンリッチメントツールを使用した大規模な遺伝子リストの分析は、純粋な統計的ソリューションというよりも、探索的データマイニングの手順である。最良の分析的結論は、研究者のバイオ知識、統合されたアノテーションデータベース、コンピューティングアルゴリズム、および統計的手法から導出されたエンリッチメントP値を使用して作られる。 (一部略)最後に、現在のエンリッチメント分析方法のニーズが満たされていないことと制限が存在するために、新しいエンリッチメントツールの開発と活動の情熱が続くことが予想される。新しいツールを評価するための標準が、本分野の成長を促進する。

help

https://david.ncifcrf.gov/helps/functional_annotation.html#EXP2

Frequently Asked Questions

https://david.ncifcrf.gov/content.jsp?file=FAQs.html

A Quick Tutorial/An Example to Use the DAVID Bioinformatics Resources

https://david.ncifcrf.gov/helps/tutorial.pdf

books

david: Database Annotation Visualization Integrated Discovery

DAVIDのこれまでのcitation

https://scholar.google.com/citations?user=dMn7gzYAAAAJ

使い方

https://david.ncifcrf.gov/home.jsp

基本的な使い方は統合TVの動画をみてください。わかりやすく説明されています。

DOI: 10.7875/togotv.2012.079

DOI: 10.7875/togotv.2013.033

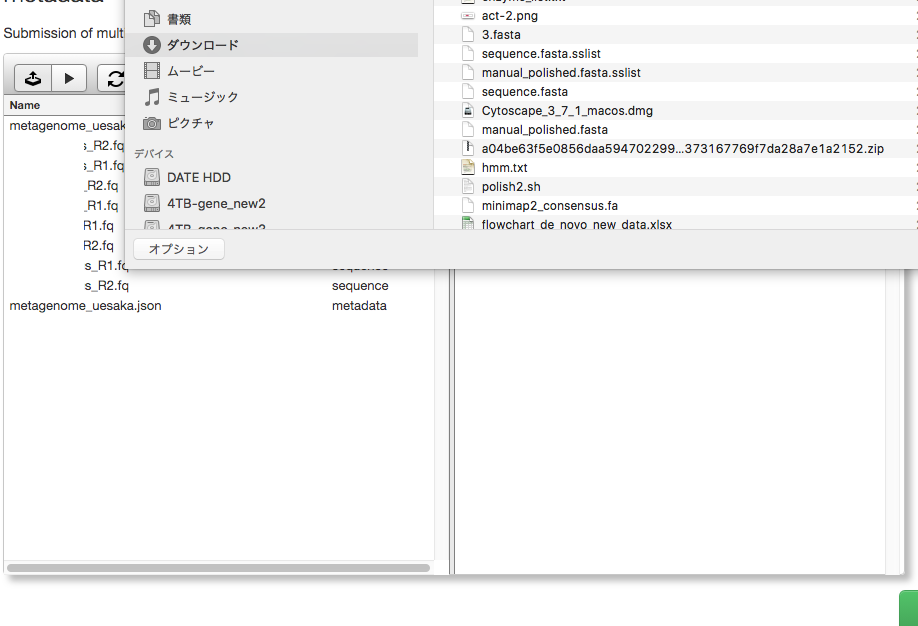

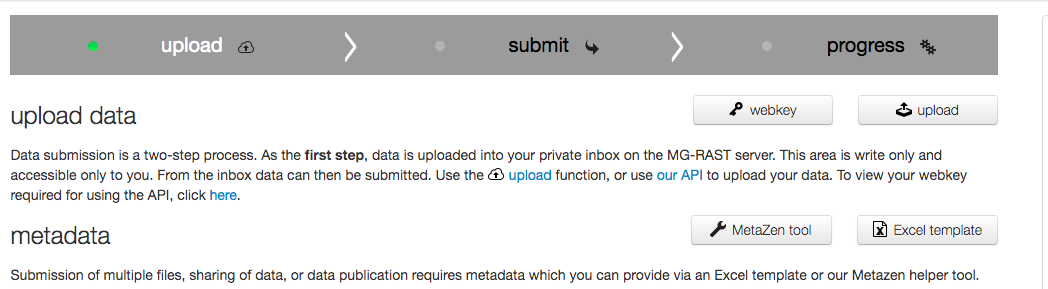

ここではGene IDの変換ツールについて紹介する。

https://david.ncifcrf.gov/helps/conversion.html#submission

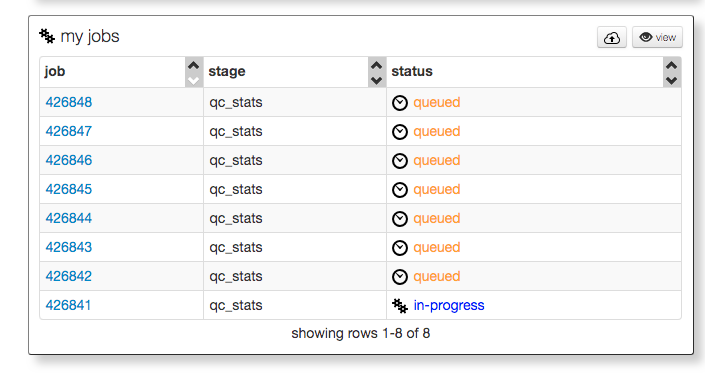

1、左側のメニュー上のUploadタブに切り替える。Gene IDのテキストをアップロードするかウィンドウ内にペーストする。

変換前のIDのタイプを選択し、submitする。

2、メニュー上からリストタブに切り替える。List managerにより複数のファイルを同時に扱うことができるようになっている。

helpより転載

特定の生物種のIDに限定するなら、生物を選ぶ。左下のリストマネージャで、変換するファイルを選択する。

変換先のIDを選ぶ。submit to conversion toolをクリックして変換スタート。

変換結果。

変換したIDを使い、ダイレクトにFunctional enrichment解析を実行することもできるようになっている(右の表の上の緑のボタンをクリックしてリストマネージャに登録する)。

結果をまとめた表を見てみる。149 ID全て変換に成功している。

変換したIDは右上のリンクからダウンロードできる。

どちらかと言えば、DAVIDは昔アフィメトリクスのアレイのID変換でお世話になっていました。

引用

Bioinformatics enrichment tools: paths toward the comprehensive functional analysis of large gene lists

Huang DW, Sherman BT, Lempicki RA

Nucleic Acids Res. 2009;37(1):1-13

Systematic and integrative analysis of large gene lists using DAVID Bioinformatics Resources

Huang DW, Sherman BT, Lempicki RA.

Nature Protoc. 2009;4(1):44-57

参考

遺伝子 ID 変換 | 複数のデータベースを利用してデータ解析を行うときに必要な遺伝子 ID 変換の方法

関連