ハイスループットシークエンシング技術の出現により、集団に特異的な構造変異(SV)および疾患におけるそれらの可能な役割の同定にかなりの関心が集まっている。様々な構造変化の中で、コピー数変動(CNV)は、ヒトゲノムの多様性および疾患に有意に寄与することが示されている。 CNVsは、ヒトゲノムの約9.5%に及ぶサイズ50 bp以上、おそらくは1 MbpのDNA断片の欠失および重複を含む[論文より ref.1]。これは、遺伝子によりgene dosage imbalance (gene dosage wiki)または遺伝子破壊、または非コード遺伝子および調節因子の発現の変化を介して、タンパク質コード領域の改変につながる可能性がある。

CNVの形成は、主に複製の不正確な修復および間違いによって引き起こされる。 DNA double strand breaks(DSB)の主要な修復機構の1つは、相同組換えである。修復機構は、DSBを別の相同領域に位置合わせしないで、非対立遺伝子相同組換え(NAHR)を生じる(反復および断片的重複の助けを借りて)。このメカニズムは、通常、再発性CNVの形成において観察される。 DSB部位における別の修復機構は、non-homologous end joining(NHEJ)およびmicrohomology-mediated end joining(MMEJ)を含み、欠失/挿入(リピートによって援助される)をもたらし得る。 NAHRとは異なり、これらのメカニズムはDSBに参加するためのテンプレートを必要としない。 CNVはまた、複製プロセスにおけるミス、すなわちポリメラーゼスリップおよび鋳型交換のために生成され得る。テンプレートの切り換えでは、DNA複製フォークが停止し、DNA鎖伸長が停止し、別の複製DNA断片に移行し、フォークストールとテンプレートスイッチング(FoSTeS)と呼ばれるプロセスを再開する。このメカニズムは、非反復CNVの生成をもたらす。 Mobile element insertion(MEI)は、転位性エレメントがコピーを作り、逆方向反復(レトロトランスポゾン、DNAトランスポゾンおよび内因性レトロウイルスによって媒介される)に隣接する新しい位置への挿入を可能にするメカニズムである[ref.2,3]。

伝統的なkaryotyping、 fluorescence in situ hybridization(FISH)、およびアレイベースのcomparative genomic hybridizationarrayCGH)および一塩基多型(SNP)アレイなどのアレイベースの方法などの従来のアプローチは、現在、ハイスループットの次世代シーケンス(NGS )ベースの手法を使用している。 NGSデータにおけるCNVの検出に使用される様々な戦略は、ペアエンドマッピング(PEM)、スプリットリード(SR)、カバレッジデプス(DoC)、デノボアセンブリ(AS)およびそれらの組み合わせ方法である。これらのアプローチのそれぞれには、独自の長所と短所があり、特定のアプローチによってCNVの完全なスペクトルの検出が制限されている。例えば、PEMおよびSRベースのアプローチは、小さなCNVを正確に検出するが、挿入サイズより大きな挿入の予測には適しておらず、低複雑度の領域およびセグメント重複でCNVを同定できない。De novoアセンブリベースの方法は、これらの方法がリファレンスベースのアライメント結果とは独立しているため、新規な遺伝子変異をバイアスなく予測するアプローチを提供している。しかしながら、これらの方法は、30倍以上のカバレッジを必要とし、計算要求量が高くなる。カバレッジ・オブ・カバレッジ(DoC)ベースのアプローチは、シングルリードデータのバリアント領域の絶対的なコピー数を決定する能力があるため、最も一般的だが、CNVコールでの正確なブレークポイント予測能で苦しんでいる。

本研究では、DoCベースのアプローチにおけるさまざまな問題を強調する。DoCベースのアプローチは、リードデプスがDNA領域のコピー数にほぼ比例するという仮定に基づいている。しかしながら、様々なシステマティックバイアスのために、CNVの検出はそれほど簡単ではない。リードデプスに影響を及ぼす2つの主なバイアスは、GCバイアスおよびmappabilityバイアスである[ref.3 pubmed]。これらを補正するため、データ前処理は重要なステップであり、さまざまなアプローチが提案されている(論文 表1)。 GC含量はヒトゲノムに沿って均一ではなく、PCR増幅プロセスはバイアスを引き起こし低GCまたは高GC領域からのリードを少なくする。これは、GCバイアスと呼ばれる低GC領域または高GC領域でのリードデプス(RD)信号を正確に推定する際にバイアスを導入する。低GCおよび高GC領域のフィルタリング、GC含量に基づくビンのリードデプスの標準化(コントロールサンプルがない場合)、またはケースコントロールサンプルの対応するビン内のコピー数比を使うことは、このバイアスに対処するのに役立つ。 DoCベースのアプローチでCNVコールに影響を及ぼすもう1つの大きな偏見は、mappabilityバイアスと呼ばれるあいまいなリードの処理である。アライメントのステップでは、あいまいなリードは、 ベストスコアのポジション、k個のベストスコアのポジション、すべての可能なポジション[ref.4]、または可能なポジションのうちの任意の1つにランダムに割り当てられる[ref.5,6]。これは、不均一なリードデプスをもたらす。この問題は、ショートリード(36〜150bp)の場合に顕著である。マッピング可能領域をフィルタリングするための適切な閾値を選択すること、および/またはビンのmappability scoreに関してビン内のリードを正規化することは、このバイアスに対処するのに役立つ。この研究では、iCopyDAVを使用して、GCバイアスおよびmappabilityバイアスの適切な処理が、ビンのサイズ、検出されるCNVのタイプおよびシーケンシングカバレッジに依存することを示す。

DoCベースのアプローチのもう1つの主要なステップは、segmentation(以下セグメンテーション)である。このステップの目的は、類似の強度のリードデプス信号をクラスタ化することであり、平均リードデプス信号から逸脱するものは、バリアント領域として識別される。リードデプス信号は、シーケンシングエラー、マッピングエラー(マルチプルマッピング、ミスマッチ)、SNPおよびindelsの存在のために非常にノイズが多い。セグメンテーションにおける主な課題は、真のコピーバリアント領域と偽のバリアント領域とを区別することである。変異検出アルゴリズムとそれに続くマージ手順[ref.13]や、リードデプス信号がある確率分布に従うと仮定した統計的な仮説検定(e.g., Poisson, negative-binomial)に大別される様々なセグメンテーション手法が提案されている(論文 表1)[ref.9,11]。 iCopyDAVを使用して、これらのメソッドがアンダーカットまたはオーバーカットの問題を抱え、検出されるCNVのタイプとサイズ、およびデータのシーケンス範囲に応じて慎重に選択する必要があることを示す。

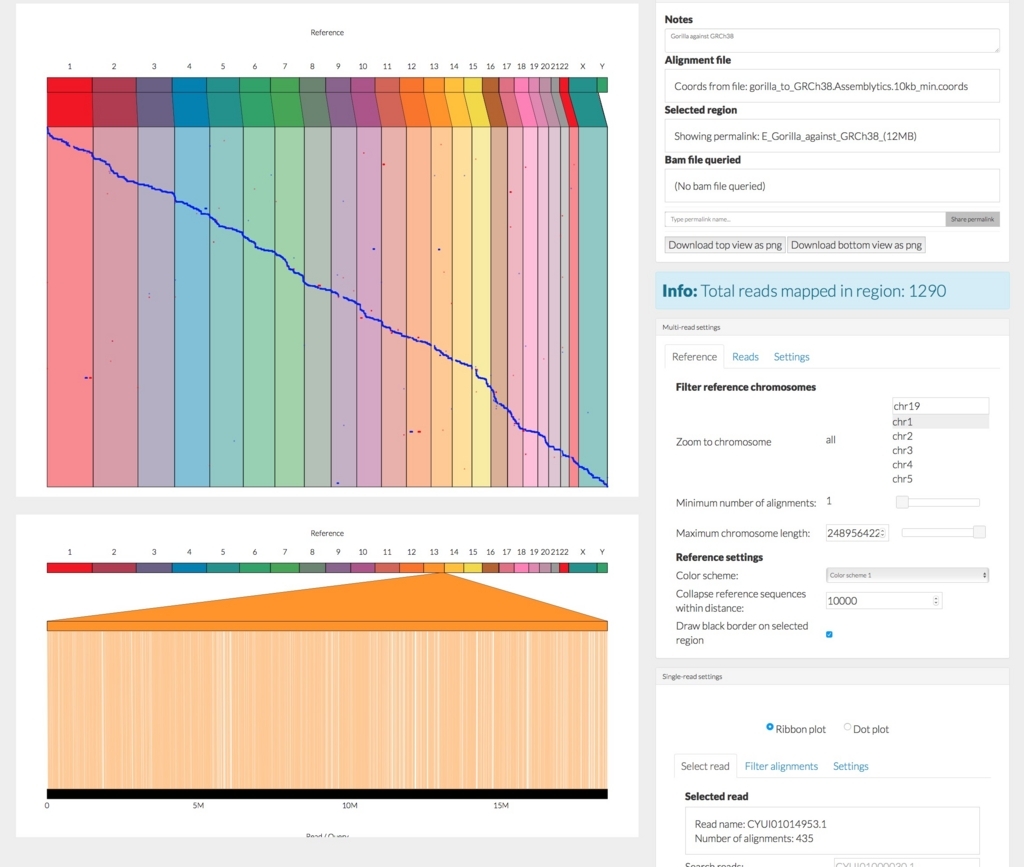

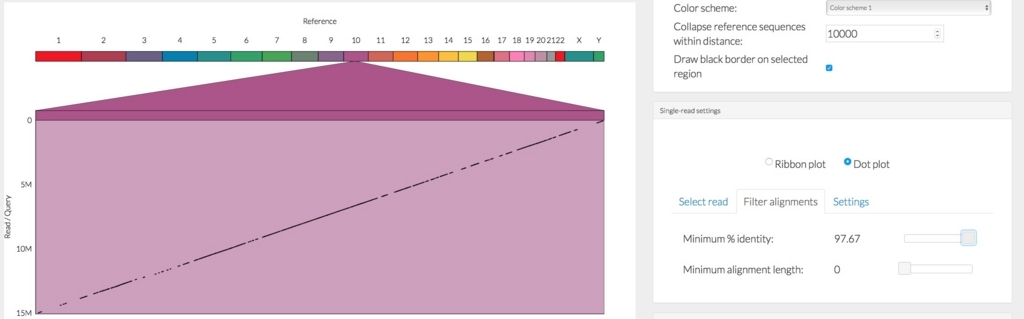

CNVの機能的影響を分析するために、様々な機能要素、すなわちタンパク質コード遺伝子、非コードRNA、調節因子(プロモーターおよびエンハンサー)などとの重複に関する情報、既知のCNVおよび疾患関連が望ましい。多数の独立した注釈ツールがCNVの機能注釈(表2にまとめられている)に利用可能であるが、本発明者らの知見によれば、注釈コンポーネントはCNV検出ツールにはない。CNVの視覚化もまた重要な特徴であり、染色体/ゲノムにわたるCNVの分布を分析し、CNVクラスターを同定するのを助ける。

以前の研究[ref.36,37]は、複数の方法を使用すると、単一のアプローチと比較してCNV予測の信頼性を改善できることを示している。PEM、SR、DoCメソッド(CNVer [38]、ERDS [39]、Clever [40]、HugeSeq [41]、SVMerge [42]、MetaSV [43]など異なる戦略に基づいたさまざまなツールの出力をマージする統合されたプラットフォームが開発されている。これらのプラットフォームは単一のアプローチよりも優れているが、アプローチのタイプを選択する柔軟性はない。また、これらのプラットフォームのほとんどはアノテーションとビジュアライゼーション機能を提供していない。したがって、単一プラットフォーム上の予測されたバリアントコールとバリアントのアノテーションの両方を提供するエンドツーエンドパイプラインの必要性が明らかに存在する。この目的で、著者らは、DoCアプローチに基づいた全ゲノムNGSデータにおけるCNV検出のための統合プラットフォームiCopyDAVを開発した。データ前処理(GCバイアスおよびマッピングバイアスの処理)、セグメンテーション(分割および凝集アプローチ)、CNVコール(タイプおよびコピー数)、アノテーション(機能要素、既知のCNV、臨床関連性および構造的特徴)およびビジュアライゼーション(GCプロファイルおよびCNV分布プロット)。適切なビンサイズの選択から、GCおよびマッピング可能バイアスの除去方法、セグメンテーション方法まで、エンドツーエンドソリューションを提供する点で、さまざまな統合プラットフォームとは異なる。したがって、iCopyDAVでは、ユーザーは、検出されるCNVのタイプとサイズ、およびデータのシーケンス・カバレッジに応じて、ワークフローをカスタマイズできる。必要に応じて、ユーザーはiCopyDAV内のさまざまなワークフローからのCNVコールをマージすることもできる(結合または交差)。 iCopyDAVの重要な特徴は、高いカバレッジのシーケンスデータでも(エキソーム解析など)、セグメント化アルゴリズムの並列化による高い計算効率により、CNVの検出が高速化されていることである。

公式HP (Docker imageやデータ、マニュアルあり)

iCopyDAV

インストール

公式ページのdockerを使い、mac10.12に導入した。

本体 Github

https://github.com/vogetihrsh/icopydav

コンテナのダウンロード。

wget http://bioinf.iiit.ac.in/icopydav/icopydav.tar

sudo docker load -i iCopyDAV.tar

#立ち上げる

Sudo docker run -i -t <Image ID>

#実行ファイルのあるroot/icopydav/に移動する。

cd /root/icopydav/

> ./calOptBinSize --help

# ./calOptBinSize --help

Usage: calOptBinsize -c <config file> -i <input BAM>

>./prepareData --help

# ./prepareData --help

Usage: prepare_data -m <map file> -g <gc content file> --win <window_Size> --genome_file <Genome file> -o <output Prefix>

> ./pretreatment --help

# ./pretreatment --help

Usage: preprocess -i <input BAM> -o <output Prefix> -m <mappability file> -z <bin file>

> ./runSegmentation --help

v# ./runSegmentation --help

Usage: runSegmentation -o <output prefix> <one or both segmentation flags (-t, -d)>

> ./callCNV --help

# ./callCNV --help

Usage: callCNV -o <output Prefix> -z <window file> <genome-flag>

For additional parameters please go through read me

> ./annotate --help # (*1)

# ./annotate --help

Usage: annotate -i <input bed> -o <output prefix> <genome flag>

Please go through ReadMe for futher help

> ./plot --help

# ./plot --help

Usage: plot -i <input bed> -o <output prefix> <genome flag>

*1アノテーションはhg18とhg19のみ可能。

--データの送り方について--

別のターミナルウィンドウを開き、データを送る。

#コンテナIDを確認

sudo docker ps

#確認したIDのルートにデータを送る。ここでは~/fastq/にあるinput.fqを送る。

docker cp ~/fastq/input.fq containerID:.

解析したデータをコンテナの外に送る。上と同様にosx側から操作。

docker cp containerID:/root/icopydav/files .

最初から共有ディレクトリを指定して立ち上げても良いと思います。

ラン

ランにはconfigファイルが必要。レポジトリのルートにおいてあるconfig.txtは以下のような内容になっている。

# cat config.txt

#These are comments

# Minimum window size allowed

# You can comment any parameter by adding '#' before it. For default values

# of parameters please through the README.md

minSize=100

genomeSize=10000000

percCNLoss=0.05

percCNGain=0.05

fdr=0.01

overDispersion=3 # Value = 2 for low coverage data

ploidy=2

必要に応じて修正する。

すでにdockerコンテナ内に入っているものとする(一旦抜けるにはCtrl+PQ、再ログインはdocker psでIDを確認して docker attach < ID>)。

公式からダウンロードできるテストデータを解析してみる。

wget http://bioinf.iiit.ac.in/icopydav/test.tar

マニュアルの通り進める。

# CALCULATE OPTIMAL BIN/WINDOW SIZE

./calOptBinSize -c config.txt -i Testing_files/Test.bam

# DATA PREPARATION

./prepareData -m Testing_files/chr21.dat -g Testing_files/chr21.gc --win 100 --genome_file Testing_files/chr21.gen -o output

# PRETREATMENT STEP

./pretreatment -i Testing_files/Test.bam -z output_100.bin --mapfile output_100.map -o output --gcfile output_100.gc

> head -n 5 cbs_output_annotated.bed

# head -n 5 cbs_output_annotated.bed

#c1 c2 c3 c4 c5 GENE LOCATION Gene_Structural_Elements DGV_accessions Enhancers miRNA_target_sites Segmental_Duplications Interspersed_repeats Tandem_repeats ClinVar_pathogenicity ClinVar_Phenotype OMIM_PHENOTYPE DECIPHER EXAC Priority

chr21 9719800 9724000 1 34.9907 . . . dgv2455e59,dgv2456e59,dgv7727n54,dgv7728n54,dgv7729n54,esv28756,esv5204,esv6965,esv8991,nsv586875,nsv586876,nsv820334,nsv834035 . . . . chr21:9719768-9725583_TR,chr21:9719769-9725584_TR . . . . . low

chr21 9724000 9725000 1 75.7965 . . . dgv2455e59,dgv2456e59,dgv7727n54,dgv7728n54,dgv7729n54,esv28756,esv5204,nsv586875,nsv586876,nsv820334,nsv834035 . . . . chr21:9719768-9725583_TR,chr21:9719769-9725584_TR . . . . . low

chr21 9725000 9725400 1 32.238 . . . dgv2455e59,dgv2456e59,dgv7727n54,dgv7728n54,dgv7729n54,esv28756,esv8133,nsv586875,nsv586876,nsv820334,nsv834035 . . . . chr21:9719768-9725583_TR,chr21:9719769-9725584_TR . . . . . low

chr21 9725400 9726400 1 13.5252 . . . dgv2455e59,dgv2456e59,dgv7727n54,dgv7728n54,dgv7729n54,esv28756,esv6494,esv8133,nsv586875,nsv586876,nsv820334,nsv834035 . . . . . . . . . . low

# SEGMENTATION

./runSegmentation -o output -t -d

output_cbs_pCNVD.output、output_tvm_pCNVD.outputができる。

# POSTPROCESSING AND CNV CALLING

./callCNV -o output -z output_100.bin --hg18

# ANNOTATION

./annotate -i output_tvm_pCNVD.bed -o tvm_output --hg18

./annotate -i output_cbs_pCNVD.bed -o cbs_output --hg18

# PLOT (visualization)

./plot -i output_cbs_pCNVD.bed -o tvm --hg18

./plot -i output_cbs_pCNVD.bed -o tvm --hg18

osxにコピーする。

docker cp containerID:/root/icopydav/tvm.png .

docker cp containerID:/root/icopydav/cbs.png .

画像を開く。

> open tvm.png

> open cbs.png

引用

iCopyDAV: Integrated platform for copy number variations-Detection, annotation and visualization

Dharanipragada P, Vogeti S, Parekh N.

PLoS One. 2018 Apr 5;13(4):e0195334.